Bio

Guy Van den Broeck is an Associate Professor and Samueli Fellow at UCLA, in the Computer Science Department, where he directs the Statistical and Relational Artificial Intelligence (StarAI) lab. His research interests are in Machine Learning, Knowledge Representation and Reasoning, and Artificial Intelligence in general. His papers have been recognized with awards from key conferences such as AAAI, UAI, KR, OOPSLA, and ILP. Guy is the recipient of an NSF CAREER award, a Sloan Fellowship, and the IJCAI-19 Computers and Thought Award.

Title

Artificial Intelligence can learn from data. But can it learn to reason?

Abstract

Modern artificial intelligence, and deep learning in particular, is extremely capable at learning predictive models from vast amounts of data. Many expect that AI will go from powering customer service chatbots to providing mental health services. That it will go from personalized advertisement to deciding who is given bail. That it will go from speech recognition to writing laws. The expectation is that AI will solve society’s problems by simply being more intelligent than we are. Implicit in this bullish perspective is the assumption that AI technology will naturally learn to reason from data: that it can form trains of thought that “make sense”, similar to how a mental health professional, a judge, or a lawyer might reason about a case, or more formally, how a mathematician might prove a theorem. This talk will investigate the question whether this behavior can be learned from data, and how we can design the next generation of artificial intelligence techniques that can achieve such capabilities, focusing on neuro-symbolic learning and tractable deep generative models.

Replay (需要科学上网和观看密码)

Slides

一韬老师按

Guy Van den Broeck现为UCLA的长聘副教授,曾获斯隆奖(年轻科学家最受瞩目的奖项之一)、IJCAI计算机与思想奖(人工智能领域35岁以下最高奖之一)和多篇顶会最佳论文。Guy可以说是全球中青年一代中最懂逻辑和概率推理的学者。我们来思考一个简单的扑克问题。一副牌里,第一张牌是红心的概率是多少?第二张呢?第三张?我们都可以快速反应过来,无论是第几张牌,红心的概率都是1/4。那为什么现有在各种复杂任务上都展现强大性能的神经网络,没法快速推导出这样的答案呢?我们现在的人工智能系统在经过过去井喷式的10年发展,还有什么根本不足吗?第一代人工智能的符号主义,和当今盛行的连接主义之间有什么共性,可以互相借鉴的地方吗?在人工智能迈向复杂认知推理的无人区领域,Guy的研究显得越来越重要。希望这次讲座能给大家启发,在普遍低头调参的当下,大家能不忘随时仰望AI研究的广阔天空。

p.s. 皮一下,大家知道Guy的正确发音是什么吗?

Poster

Notes

Organized by Anji Liu.

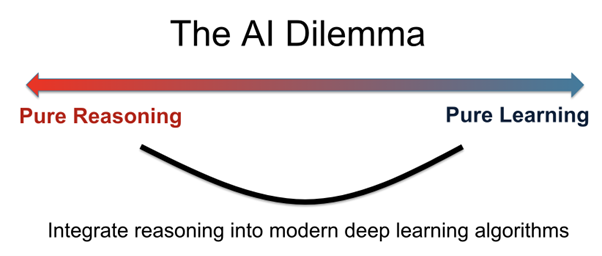

以神经网络为代表的连接主义模型在很多任务上取得了很大的成功。在本次讲座中,Guy Van den Broeck将带领大家进一步讨论这类模型是否已经很好地解决了AI中的一个重大问题—-逻辑/概率推理。在上个世纪,AI领域刚刚兴起的时候,大量学者们坚信AI的智能可以通过纯粹的推理(reasoning)来体现:只要将各领域知识以形式化语言(formal language)的形式存储下来,并在使用的时候通过逻辑/概率推导得到对应结果即可。

然而这种纯推理的范式很快遇到了一个巨大的挑战:形式化的领域知识的获取难度非常高,且很多知识难以形式化地描述。比如,我们可以用精确的数学语言证明一个数学定理,但是我们很难将想到这一证明方式的过程用形式化语言描述出来。面对这个问题,学者们开始转向另一个AI范式—-基于纯学习的范式。以神经网络为代表,这类模型直接从大量数据中学习统计特征。相比AI的逻辑范式,这类模型对于数据的形式化程度要求很低,因此我们可以从互联网上获取大量数据。

那么神经网络这类连接主义模型能否解决所有的AI问题呢?在本次讲座中,Guy展示了一些神经网络会失败的例子。

本次讲座从三个主题引入:

- Learning和reasoning之间的悖论。

- 将概率推理和深度学习相结合,得到tractable deep generative models。

- 将逻辑推理和深度学习相结合,在符号知识的帮助下进行模型学习。

Learning和Reasoning之间的悖论

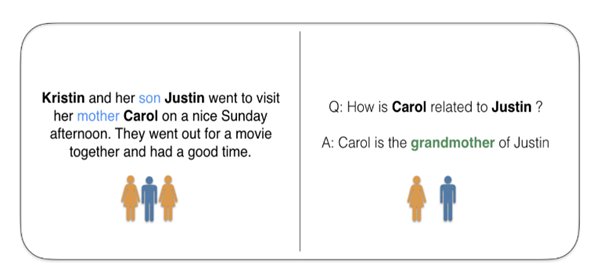

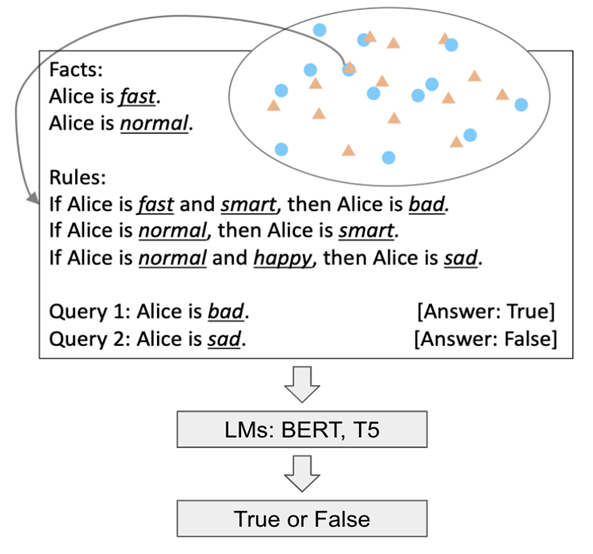

首先,我们想知道现有的大语言模型能否进行逻辑推理。如下图,我们用SimpleLogic这个数据集来进行分析。SimpleLogic的每个数据包含一些事实(fact)和一些规则(rule),模型的目标是预测某些未出现在输入的事实是否是正确的。我们想知道Bert,T5这类模型是否能通过这些数据集学会逻辑推理(deduction)。

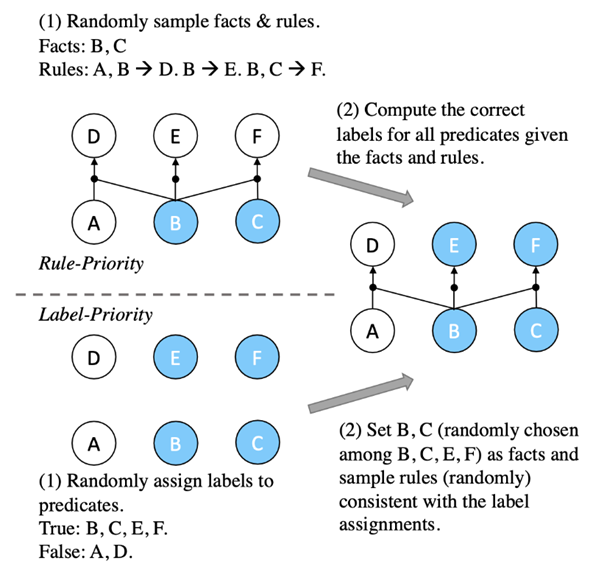

为了验证这些语言模型做逻辑推理的能力,我们通过两种方法抽样训练样本。第一种是随机抽取一些事实和规则,然后计算所有正确的新事实作为训练数据。第二种是随机选取事实和正确的新事实,再抽样使得新事实成立的规则。我们发现在两类抽样方法的样本中训练的模型都能在对应抽样方法的测试集达到非常高的准确率(>99%),但如果我们在测试集中更换抽样方法,测试准确率将大幅下降。这说明这些语言模型并没有真正学会做deduction。可能有的人会说大语言模型不够capable来学会做deduction,但Guy等人证明了存在一组参数使得BERT可以以100%正确率做任意deductive reasoning。

这个实验告诉我们在取得高测试准确率和学会推理之间存在巨大的gap,且当前的大语言模型还无法很好地解决这一问题。

Tractable deep generative models

在意识到纯神经网络模型在推理能力上的弱环之后,Guy讲解了一类可以将深度学习和概率推理结合的模型—-tractable deep generative models。具体而言,Guy介绍了概率电路(Probabilistic Circuits)模型,并解释了为什么这些模型是tractable的:他们可以准确且快速地回答大量probabilistic queries,如边沿概率和条件概率。

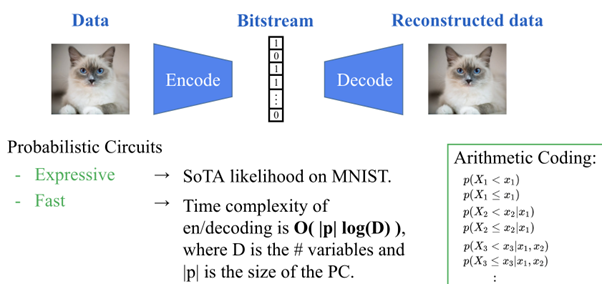

概率电路的tractability使得其在lossless data compression这个下游任务上取得了一定的成功。具体而言,基于概率电路的lossless compression可以在得到SOTA压缩率的基础上,比其他基于神经网络的压缩算法快5至40倍。

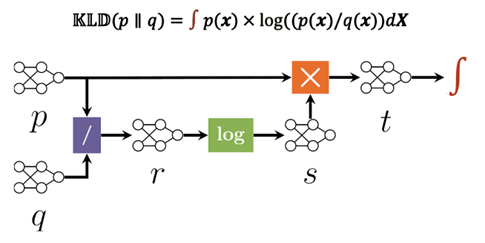

Guy接着介绍了如何快速得到运算更为复杂的probabilistic queries算法的方法。具体而言,我们只需将目标query(如KL散度)分解成乘法、除法、算log等基本操作,并推导每个基本操作的做法,就可快速计算大量复杂的queries。

将逻辑推理和深度学习相结合,在符号知识的帮助下进行模型学习

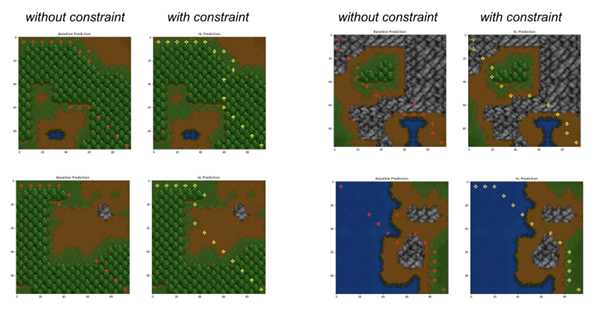

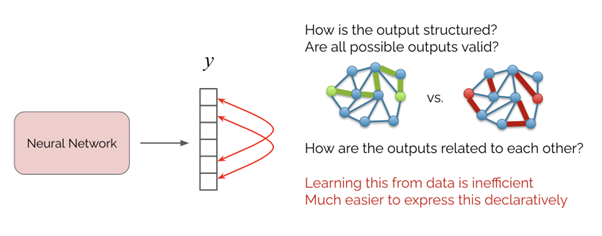

在最后一部分中,Guy介绍了如何在符号知识的帮助下提升神经网络的性能。考虑如下最短路径规划任务。这里神经网络的输入是一个地图,而输出是其上的最短路径。这里我们已知的逻辑知识是,我们希望网络的输出永远是一个路径。如果使用一个简单的神经网络,这件事情是无法保证的。Guy介绍了如Semantic Loss、Semantic Probabilistic Layer等方法来在神经网络的输出空间中引入逻辑限制条件(constraint)。

此外,Guy介绍了Pylon package。这是一个基于PyTorch的package。我们可以轻松的在神经网络中加入各种各样的输出空间constraint。

结语

Guy的讲座给现下调神经网络为主旋律的AI research提供了一些新的视角:现有AI模型到底多大程度地解决了推理的问题?虽然纯学习的方法在大量任务中取得了不错的结果,这类方法还不能解决很多重要的AI问题。Guy的讲座启发我们,在普遍低头调参的当下,不忘随时仰望AI研究的广阔天空。